原创:亲爱的数据

科学家、畅销书作者,企业家,Gary Marcus(马库斯)是典型的“斜杠青年”。

生于1970年2月8日的水瓶座。

马库斯他是心理学家,且属于心理本土主义思想流派。他的一本书《心灵的诞生》(2004)从本土主义的角度描述了基因影响认知发展的方式

2015年,Marcus与他人共同创立了一家机器学习初创公司Geometric Intelligence。

2019年,马库斯与iRobot联合创始人兼Roomba的共同发明者罗德尼·布鲁克斯(Rodney Brooks)一起创办了初创公司 Robust.AI。

2020年2月,《The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence》(迈向强大的人工智能的四个步骤)是他的著名文章,远不止批评,他提出很深邃的意见。

2022年10月,又写了一篇著名的文章,《人工自信:即使是最新的、最时髦的人工通用智能系统也会被同样的老问题所阻碍》,《科学美国人》,第327卷,第2期。

下图是:《科学美国人》 早期封面

马斯库对AI的批评往往非常及时,或者说“第一时间”更为合适。

又或者说可以说,“马斯库老师,怎么到处都有你?”

2023年8月24日,美国的一家人工智能安全中心(Center for AI Safety)发表了一篇论文,论文中,作者介绍了灾难性人工智能风险的四个主要来源:

-恶意使用

-人工智能竞赛

-组织风险

-流氓人工智能

——《An Overview of Catastrophic (AI Risk灾难性AI风险概述)》

马库斯2023年3月28日发表题为“人工智能风险≠通用人工智能风险”的文章。

马库斯点评道,灭绝风险不等同于灾难性风险。

2023年,7月31日,马斯库还发表了一篇论文谈到了可信AI的16项能力,是和他的好朋友Douglas Lenat。虽然是认知心理学家,可是不耽误他发人工智能的论文。

谁能料到,2023年8月31日,美国计算机科学家,AI领域大师Douglas Lenat逝世,马库斯发文悼念。

由此可见,马库斯是一位“情深义重”的人。

文章部分内容如下。

道格·莱纳特是我见过的最聪明、最尖刻、最有趣的人之一。如果说马文·明斯基(Marvin Minsky)、约翰·麦卡锡(John McCarthy)和艾伦·纽厄尔(Allen Newell)等人是第一批深入思考符号人工智能(symbolic AI)如何运作的人,那么道格就是第一个努力让它真正运作的人。在符号人工智能中,机器可以操纵明确的类似语言的表征。我的整个职业生涯都在争论神经网络和符号人工智能之间的一致性,在这个等式的严格符号方面,Lenat比我早了好几光年,他不仅比我更深入这些战壕,而且是许多战壕的建筑师。

……莱纳特在生命的最后40年里发起并指导了一个名为Cyc的项目,这是一个将所有常识编纂成机器可解释形式的努力。

他在文中指出了很多人忽略的一项工作:Cyc(以及后来孵化它而成立的母公司Cycorp)。

这里不得不再讲一次Cyc知识规则,这是一个始于1984年的项目,开始的目标是“手写规则”,当然,这要写大量的规则,比如“每棵树都是植物”之类的,经年累月现在已经有30万个概念了。这种为了教会“计算机”知识的努力,后面的就要学习推理了,包括我们耳熟能详的“演绎推理”“归纳推理”“上下文推理”。

大多数年轻的人工智能研究人员甚至从未听说过它。但是他们每个人都应该知道一些关于Cyc的事情。 不需要喜欢它,但他们应该了解它是什么,它试图做什么,以及他们可能会做什么来实现相同的目标。

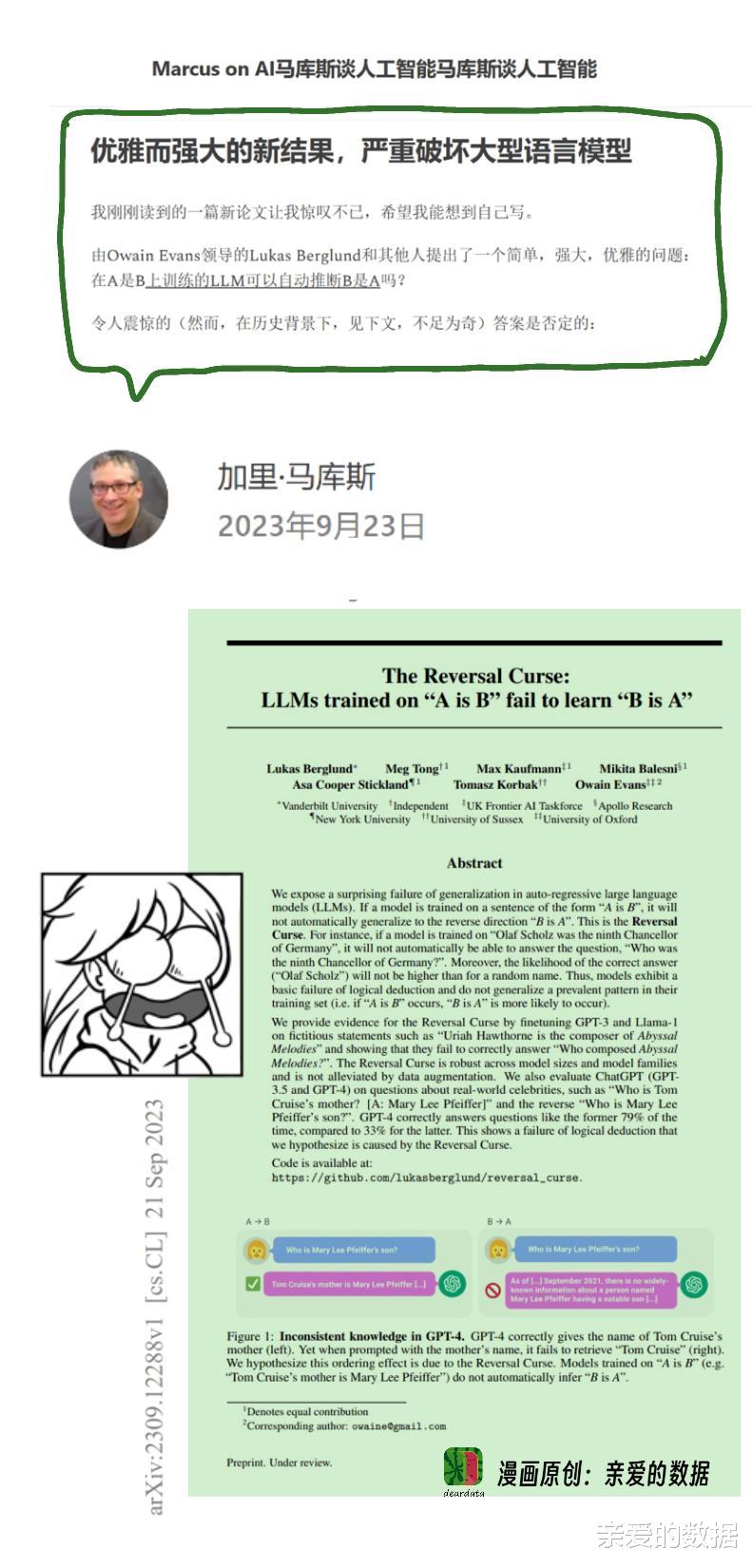

2023年9月,大语言模型(LLM)中了“「逆转诅咒」(Reversal Curse)”不会推理的论文一出,语惊四座。

文章全名:《TheReversal Curse: LLMs trained on "A is B" fail to learn "B is A"》

「乔治·华盛顿是美国第一任总统」后,它能否自动回答「谁是美国第一任总统?」?

答案是:不能。

这个问题是考察大语言能力的泛化能力的,很遗憾大语言模型没有通过测试。

马库斯老师一激动,又写了一篇长文,博客时间是2023年9月23日。

“我刚刚读到的一篇新论文让我惊叹不已,希望我能想到自己写。

由Owain Evans领导的Lukas Berglund和其他人提出了一个简单,强大,优雅的问题:在A是B上训练的LLM可以自动推断B是A吗?”

在虚构的事实中,在第一个实验中,模型的正确率为零,在名人身上,在第二个实验中,表现仍然令人沮丧。

当训练集必须包含数十亿个对称关系的例子,其中许多与这些关系密切相关,而系统仍然偶然发现这样一个基本关系时,我们真的可以说我们接近AGI吗?

论文真是打击到马库斯老师了,原本被称为“通用人工智能火花”的大语言模型,在这篇论文的拷问下,连马库斯老师都发出了灵魂一问:“我们接近AGI(通用人工智能)吗”

当然,他也通过回顾自己早年的研究,有说自己“有先见之明”的嫌疑。

这篇原本精彩的论文在最初的版本中没有注意到的是,这篇论文的历史非常非常深刻。

首先,这种失败实际上可以追溯到我自己2001年出版的《代数思维》(Algebraic Mind)一书,该书广泛关注早期多层神经网络在自由泛化普遍关系方面的失败,并给出了原则性的理由来预测这些架构的这种失败。我当时提出的问题,在这几十年中都没有真正得到充分解决。正如我当时指出的,核心问题是,在许多现实世界的问题中,你永远无法完全覆盖可能的例子的空间,而在像LLM这样缺乏显式变量和变量操作的大量数据驱动系统中,当你试图推断超出训练示例的空间时,你就不走运了。当时是真的,现在仍然是真的。

还是在2023年9月,一篇由谷歌Jeff Dean(昵称,姐夫)领导研究的项目「AI自主设计芯片」研究,被曝正式接受Nature调查。

马库斯在推特上立刻“冷嘲热讽”,如下图:

看来,跟进AI的进展,跟着马库斯老师就对了。